Rclone 远端图床本地化管理方案:以七牛云为例

早年我将大量博客配图托管于七牛云,但当时并没有在本地对图片进行统一压缩。虽云端支持图片处理,但长期积累仍面临两个问题:

- 部分图片原始分辨率和体积过大,即使经过云端处理,存储空间占用和流量成本依然偏高。

- 历史图片太多,云端管理并不友好。

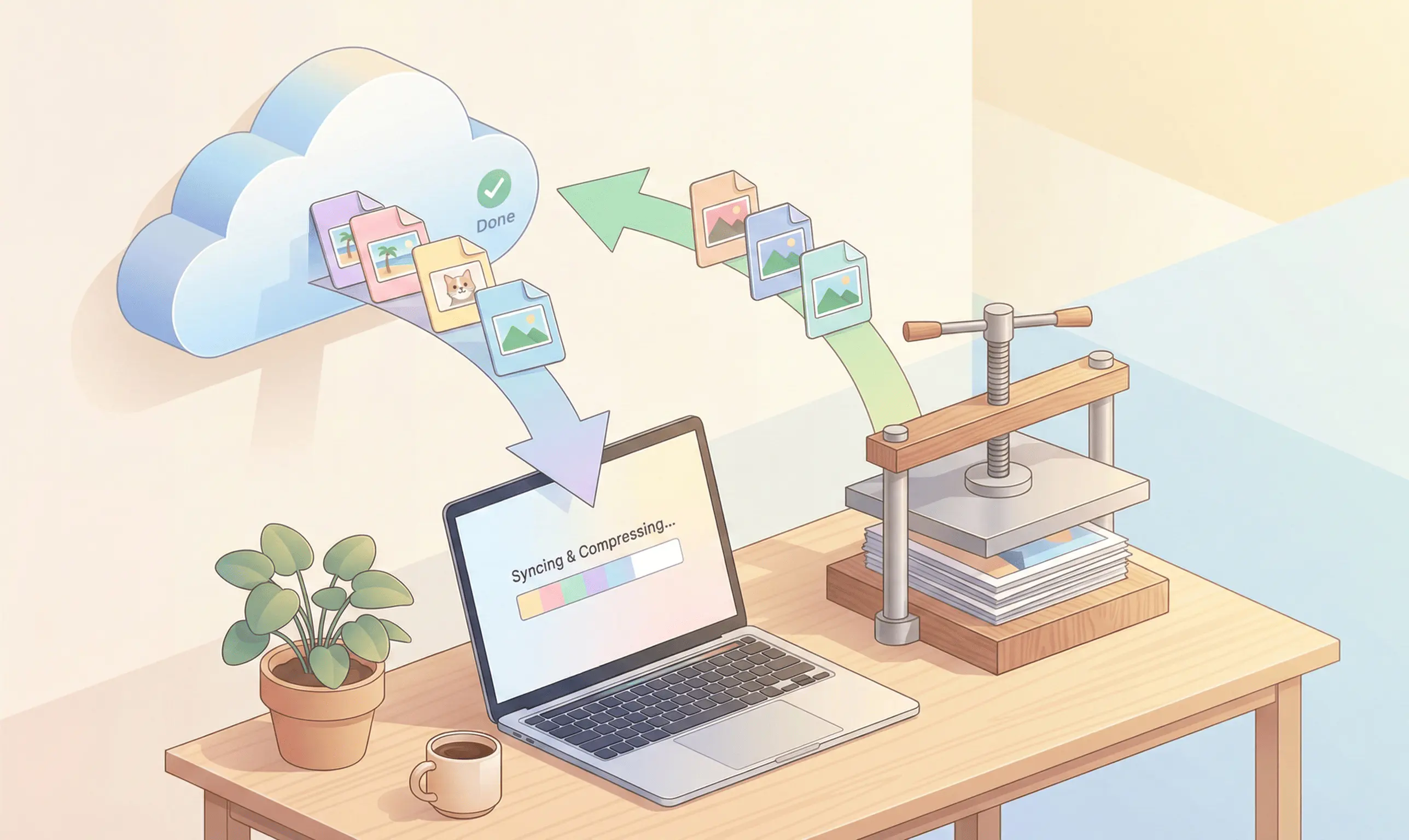

为此,我采用了一种更通用、可控的方案:「云端下行同步 → 本地批量压缩 → 上行覆盖同步」。此举既能压缩历史存量,又能建立一套可自由管理的图床库。

方案总览

- 核心组件:Rclone(支持 S3 协议)

- 处理方式:本地批量压缩(无损 / 视觉无损)

- 同步逻辑:

- 全量下载(云端 → 本地)

- 本地处理(压缩)

- 增量覆盖(本地 → 云端)

七牛云兼容 AWS S3 协议,可直接通过 Rclone 的 S3 Provider 访问,无需额外插件。

第一步:部署 Rclone

Rclone 是单文件命令行工具,无须安装,配置环境变量即可使用。

1. 获取程序

访问 Rclone 官网下载页,下载适用于 Windows 的 Intel/AMD - 64 Bit 压缩包。

2. 解压

将解压后的文件置于固定目录,例如 C:\rclone\,确保该目录下包含 rclone.exe。

3. 配置环境变量

- 按

Win键,搜索「环境变量」,进入「编辑系统环境变量」。 - 点击「环境变量」,在「系统变量」列表中找到

Path。 - 新建条目:

C:\rclone\。

4. 验证

启动 PowerShell 或 CMD,执行:

rclone --version输出版本号即表示配置成功。

注意:日常使用建议避免以管理员权限运行 PowerShell,以免权限冲突导致 Rclone 异常。

第二步:建立连接

前置准备信息:

- 七牛云 Access Key(AK)

- Secret Key(SK)

- 存储桶(Bucket)所属区域(如华东、华北等)

配置流程

执行配置命令:

rclone config输入

n新建远程连接(New remote)。name:命名连接,例如

qiniu。Storage:选择

S3(Amazon S3 Compliant Storage)。provider:选择

Qiniu(Qiniu Object Storage)。access_key_id:输入 AK。

secret_access_key:输入 SK。

region:留空回车。

endpoint:根据区域填写对应的接口地址(Endpoint):

区域 Endpoint 华东(浙江) s3-cn-east-1.qiniucs.com华北(河北) s3-cn-north-1.qiniucs.com华南(广东) s3-cn-south-1.qiniucs.com若不确定区域,请至七牛云控制台「空间管理」页面查看。

后续选项均回车保持默认。

确认配置无误后,输入

y保存,最后输入q退出。

第三步:下行同步

假设七牛云存储桶名为 7zj5r8,本地同步目录为 D:\vault\imagehosting。

执行同步命令:

rclone sync qiniu:7zj5r8 D:\vault\imagehosting --progress同步结束后,本地目录将拥有一份与云端完全一致的完整副本。

提示

执行报错?请检查存储桶名称 如果遇到找不到存储桶的错误,请务必核对七牛云控制台显示的真实名称。

比如我最初设置的名称是 imagehosting,但因名称已被占用等原因,实际存储桶名称被系统分配为 7zj5r8。请以控制台中显示的名称为准。

第四步:本地压缩

此步骤可选用脚本或可视化工具。以下使用开源工具 Caesium Image Compressor。

操作建议

- 启动 Caesium,将

D:\vault\imagehosting文件夹整体拖入界面。 - 设置压缩参数:

- Compression:选择 Lossless(无损)或 Lossy(有损,推荐质量 80~85,体积缩减显著且视觉无损)。

- 关键设置(Output Options):

- 勾选 Same folder as input(输出至原文件夹)。

- 勾选 Overwrite original(覆盖原文件)。

- 点击 Compress 开始处理。

处理完成后,文件体积将显著减小,文件名保持不变。

第五步:上行覆盖

此时本地文件已更新为小体积版本,云端仍为大体积旧文件。执行反向同步:

rclone sync D:\vault\imagehosting qiniu:7zj5r8 --progressRclone 会对比每张文件的哈希值与大小。检测到本地文件体积变小(即内容变更)后,会自动上传并覆盖云端对应文件。

进阶配置

当文件量很大时,sync 的“列目录 + 校验差异”会成为主要耗时。

此时可以通过 减少 API 请求往返 与 提高并发 来明显提速。下面给出一组常用参数(你可以直接拼到前面的同步命令后面):

# 下行同步(云端 -> 本地)

rclone sync qiniu:7zj5r8 D:\vault\imagehosting --fast-list --transfers 32 --checkers 64 --progress --exclude "Thumbs.db" --exclude "*.DS_Store"

# 上行覆盖(本地 -> 云端)

rclone sync D:\vault\imagehosting qiniu:7zj5r8 --fast-list --transfers 32 --checkers 64 --progress --exclude "Thumbs.db" --exclude "*.DS_Store"--fast-list:一次性拉取云端对象列表到内存里再比对,显著减少列举请求(更快也更省 API)。缺点是更吃内存;当对象数量极大时,可能需要降低并发或关闭该选项。--transfers 32:上传/下载并发数(默认 4)。带宽富余时可上调;如果触发限速/超时/429 等现象,优先降低这个值。--checkers 64:检查并发数(用于“找哪些文件需要传”)。通常checkers可以高于transfers,但也会增加 CPU/内存与 API 压力。--exclude:排除系统垃圾文件,避免无意义的比对与传输,例如--exclude "Thumbs.db"(Windows 缩略图缓存)、--exclude "*.DS_Store"(macOS 文件夹属性文件)。

安全警示

1. 慎用 Sync

sync 为镜像同步命令,操作不可逆。本地文件删除会导致云端文件同步删除。在压缩过程中请务必小心,避免误删。

2. 试运行机制

建议在正式上传前开启「试运行模式」(Dry Run):

rclone sync D:\vault\imagehosting qiniu:7zj5r8 --dry-run仔细检查输出日志。如果操作主要为 Update 或 Transferred,而非大量 Delete,即可去掉 --dry-run 正式执行。

结论与延伸

这套 Rclone + 本地压缩 的方案,一方面是为了解决“图片体积大”的问题,另一方面是拿回数据主权。

当建立起这套本地工作流后,可以获得三个长远的主动权:

去厂商锁定 拥有完整的本地副本意味着你随时可以“提桶跑路”。如果未来七牛云价格调整或策略变更,你可以用 Rclone 快速将本地图床迁移至 Cloudflare R2、阿里云 OSS 或 AWS S3,整个过程可能只需要一行命令。

管理体验质变 本地副本让图床资产摆脱了“云端黑盒”状态。借助熟悉的文件管理器,无论是按时间线回溯、关键词检索还是可视化清理,你都能以零延迟的流畅度掌控海量图片。

自动化拓展 熟悉此流程后,你可以用批处理(

.bat)脚本将同步与压缩命令封装,配合 Windows 计划任务实现“定期自动同步”,让图床维护真正实现自动化。未来若有更多需求,例如批量转换为 WebP 格式、添加版权水印,或清洗 Exif 隐私信息,只需在中间环节接入对应的命令行工具,即可将单一的存储升级为可高度定制的自动化工作流。